Indexar una página web es un proceso clave para potenciar tu posicionamiento SEO y optimizar las visitas con los objetivos de tráfico a tu web.

El concepto de indexar se refiere a la acción por la que los robots (o bots) de rastreo de un buscador encuentran nuestro contenido registrándolo en sus bases de datos para, posteriormente, posicionarlo cuando alguien busque una información relacionada.

En el caso de España, Google es el buscador de referencia. Que Google no indexe tu web convierte prácticamente invisible tu presencia digital. No serás mostrado en ninguna consulta de búsqueda y no obtendrás tráfico orgánico relevante para potenciar tu negocio o contenido.

El tráfico de búsqueda orgánica supone una prioridad en cualquier plan de marketing digital. En la mayoría de webs el tráfico SEO otorga más de la mitad de visitas generando, además, importantes acciones de fidelización y retención de usuarios. Todo objetivo SEO comienza por hacer que los robots de los motores de búsqueda encuentren, rastreen y logren indexar una página web.

Cada vez que añades, modificas o relacionas tu contenido web los bots de Google tardan un tiempo en detectarlo, analizarlo e incluirlo en su índice. Todo éste proceso de puede agilizar acelerando la aparición de los cambios en los resultados de búsqueda siendo la herramienta gratuita Google Search Console la principal alternativa para hacerlo.

En éste artículo vamos a detallar el proceso, además de sugerir otras útiles alternativas tanto para potenciarlo como para hacerlo más eficaz…

Temas del artículo

¿Cómo indexar una página web?

El proceso de indexado se produce cuando los robots del buscador rastrean el contenido de la web para posicionarlo en sus resultados de acuerdo a los criterios de búsqueda que hagan los usuarios. Los bots (Software diseñado para llevar a cabo el proceso de rastreo)de los buscadores están continuamente navegando por las webs, indiferentemente de su año de creación o actualización… la clave está en poder agilizar ése proceso para mostrar nuestro contenido en la mayor brevedad.

En España, Google es el buscador de mayor relevancia y una prioridad para conseguir que indexe nuestro contenido. El bot de Google rastrea gran cantidad de páginas existentes para indexarlas y añadirlas a un índice identificativo y posicionarla en función de su algoritmo. De esta forma, cuando un usuario sitúa una búsqueda en Google, el buscador revisa rápidamente sus índices para plantear qué páginas son las que están más relacionadas a mostrar en los resultados. Éstas sugerencias se plantean de forma inmediata mediante complicados algoritmos matemáticos.

Para indexar una página web es necesario, por lo tanto, un proceso de rastreo continuo, un análisis identificativo posterior para categorizar el contenido y un índice de resultados que lo hagan eficaz frente a la solicitud de búsqueda y en base a unas keywords concretas.

Es fundamental controlar el indexado regular de tus páginas más relevantes; los buscadores son la opción de acceso más directa para recibir visitas y un objetivo prioritario para generar tráfico u objetivos de conversión.

¿Cómo saber si una página web está indexada?

Como comento, los buscadores están en continuo proceso de rastreo e indexación. Podemos agilizar ésta tarea avisando al buscador y especificándole que Url debe priorizar al haber actualizado el contenido. No obstante, puede surgir la duda de saber si la página está ya ( O no…) indexada. ¿Cómo averiguarlo…?

Pues la respuesta es sencilla y muy lógica… tan sólo buscarla en el buscador mediante el comando “site:”. Dentro del cuadro de búsqueda escribe “site:” y a continuación el dominio o la url en cuestión. Por ejemplo; para buscar la página tumueblejardin.com tan sólo deberías escribir: “site:tumueblejardin.com” ; los resultados que obtendrás serán la cantidad de páginas indexadas del sitio.

No obstante, puede haber páginas solicitadas que aún no se muestran a causa de posibles penalizaciones o falta de tiempo en el proceso de indexación del mismo buscador (En unos días debería solventarse)

¿Cómo optimizar la indexación de tu web?

El proceso de indexación supone una tarea continua y regular por parte de los buscadores. Cualquier página en caché no será idéntica a la página que se modificó recientemente, cuando agregas contenido nuevo y proporcionas mayor facilidad de acceso a los motores de búsqueda, éstos rastrearán e indexarán tus páginas con mayor velocidad y eficacia.

Todo el proceso de indexación puede ser facilitado mediante ciertas “acciones de ayuda” muy favorables para agilizar el paso de los bots.

Contínua actualización de contenidos:

Actualizar continuamente el contenido será óptimo para indexar una página web o fichas de producto de tu ecommerce y acostumbrará al bot de Google a rastrear tu página con mayor frecuencia.

A medida que vayas manteniendo el ritmo de publicación acotando los periodos notarás como la aparición de los mismos será cada vez más inmediata pudiendo limitarla a cuestión de horas y cortos intervalos.

En éste punto te puede ser útil echar un vistazo a éste artículo pasado con algunas herramientas muy útiles para potenciar el contenido digital.

Es importante cuidar el contenido. Ofrecer siempre un contenido de calidad que aporte valor y genere audiencia. Y recuerda que el contenido no se limita a las publicaciones online en la página, sino también a los metadatos y otros componentes importantes para potenciar el SEO.

Potencia los enlaces internos:

Cuida mucho la red de enlaces entre las diferentes páginas de tu web. Asegurando una interconexión lógica y optimizada a SEO. Partiendo de que tu home principal esté correctamente indexada asegura que la estructura de páginas secundarias y posteriores según relevancia mantengan una relación de enlaces suficiente que no sobrepase los 200 enlaces por página.

Potencia las páginas internas más relevantes. No olvides tener en cuenta toda la estrategia de enlaces follow vs no-follow para ayudar a los robots del buscador a saber qué páginas deben estar conectadas y cuáles no. (Un enlace con el atributo rel=nofollow le dice básicamente a las arañas del buscador por donde deben rastrear)

Potencia tus enlaces entrantes: Linkbuilding

Toda estrategia de link building no define en sí la indexación, pero consigue que una vez esté todo bien implementado, ayude en las búsquedas de los motores y mejore el posicionamiento. Mediante el linkbuilding buscamos obtener enlaces de otras webs hacia nuestra página (Backlinks) que nos ayudarán a generar autoridad y confianza frente al buscador. Un aspecto a valorar para afianzar la indexación.

Es muy probable que los robots de los buscadores encuentren e indexen tu sitio cuando los sitios web que a menudo indexan se enlazan a él. Es, precisamente ahí, donde los enlaces de calidad resultan fundamentales.

Es importante recordar que un proceso de linkbulding no es una “petición de amistad”, supone una clasificación y análisis de webs que estén directamente relacionadas con nuestro contenido o servicio y fomenten la retención del usuario ofreciendo lo que éste busca. Potencia siempre una relación con otras páginas sobre la misma temática especificando el anchortext o el banner del linkeo.

Crea un Sitemap o mapa de tu sitio:

Un sitemap es un archivo que ofrece información muy útil a los bots cara a indexar una página web. Un documento que podemos alojar en nuestra propia página Web y que lista todas las páginas de forma jerárquica que queremos que los usuarios puedan encontrar. Al crear un sitemap se conforma una lista de las URL que componen el sitio web incluyendo información relevante.

Éstos archivos se pueden enviar a Google para decirle que añada todas las URL que contienen a su índice de clasificación.

La correcta definición del sitemap le resultará muy útil al buscador en su proceso de indexado facilitando una estructura clara de nuestra web y otorgando un camino de búsqueda más visual que facilite a las arañas el rastreo.

Google Search Console te ofrece una manera rápida y eficaz para generar el archivo sitemap:

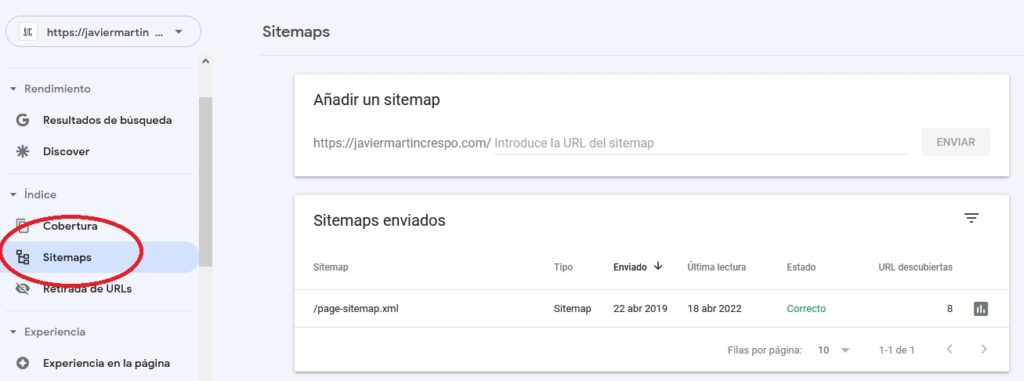

Tan sólo deberás acceder a la página de Google Search Console y en la barra lateral izquierda hacer clic en “Sitemaps”

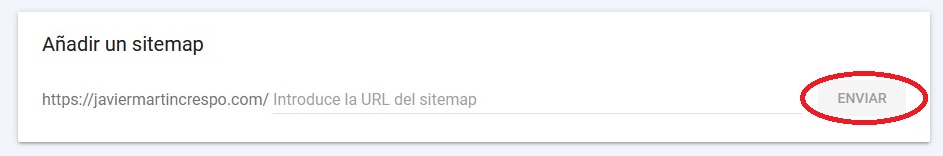

Dentro del cuadro “Añadir un sitemap” especificas el nombre (Sitemap) y clic en “enviar”

De esta forma, Google añadirá un mapa de tu sitio detallando toda la estructura de Urls del mismo y su jerarquía. Siempre será más recomendable contar con un sitemap dinámico, una opción por la que a medida que añadimos a la página nuevos contenidos el índice se actualiza automáticamente.

Control del archivo robots.txt:

El archivo robots.txt sirve para bloquear el acceso de los bots a ciertas URL del sitio web para evitar su indexación. Se trata de una opción que no optimiza el proceso de indexado pero sí ayuda a concretar qué URLs quieres mostrar en los resultados de búsqueda.

El archivo robots.txt se sitúa en el directorio raíz de tu sitio web. Mediante unos parámetros dicta qué agentes del buscador tienen acceso o no a cada URL. La estructura más simple de un archivo robots.txt aparece de la siguiente forma:

User-agent:*

Disallow:

En cuanto al fragmento; “User-agent:” se refiere al agente de usuario mientras que”Allow” o “Disallow:” especificaría el acceso o no a ciertos criterios. (Si se deja en blanco permitiríamos un total acceso al sitio)

Es importante tanto al definir el programado como si revisas una página por primera vez tener la certeza que el archivo robots.txt no defina un bloqueo de la indexación por lo que, por prioridad, si tu objetivo es mostrarse en los buscadores accede a: “dominiodelaweb.com/robots.txt.” y modifica o elimina los siguientes fragmentos:

User-agent: Googlebot</p>

<p>Disallow: /

O bien:

User-agent: *</p>

<p>Disallow: /

Ambos comandos ordenan al robot de Google que no tienen permitido rastrear ninguna página. Eliminarlos, dará acceso libre al proceso de indexado total.

Especificando un poco más en lo más básico de sus parámetros; podremos imponer el no indexar un directorio concreto:

User-agent: Googlebot

Disallow: /directorio/

Otro criterio muy frecuente sería desindexar las carpetas de administración:

User-agent: Googlebot

Disallow: /wp-admin/

Disallow: /wp-includes/

O bien, por criterios puntuales no permitir el acceso total:

User-agent: *

Disallow: /

Si por el contrario, quisiéramos bloquear una carpeta entera pero permitiendo el acceso a un archivo específico dentro de esa carpeta:

User-agent: *

Disallow: /bancos-de-jardin/

Allow: /bancos-de-jardin/bancos-de-madera-para-jardin/

Es aconsejable bloquear el acceso de todos los robots al sitio mientras éste no esté operativo o en proceso de rediseño. Posteriormente, podrás restaurar el acceso a los rastreadores una vez se encuentre operativo.

Principales métodos para indexar una página web:

Herramienta Google Search Console:

Mediante una cuenta de Google Search Console y Google Analytics puedes no sólo consultar estadísticas relevantes de posicionamiento y tráfico, sino también, agilizar las acciones de rastreo en tu página informándote de las páginas ya indexadas o avisando al buscador de la urgencia de indexar otras nuevas.

El proceso es muy sencillo, antes de nada si quieres saber si una página está ya indexada:

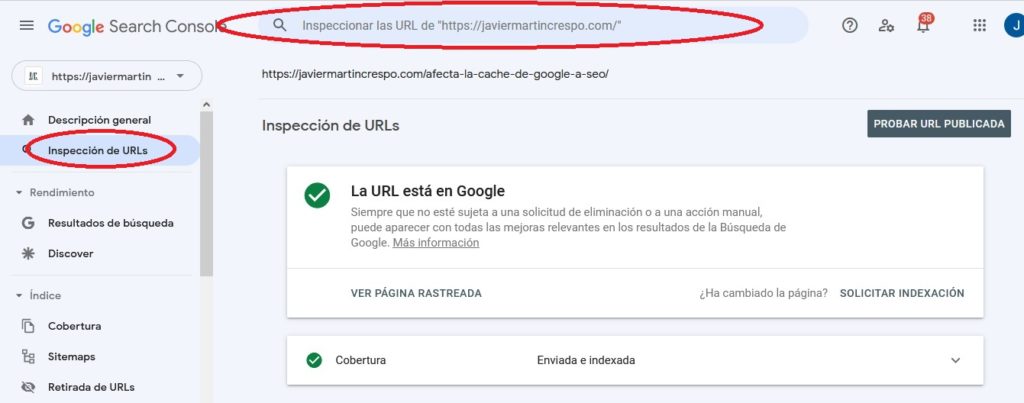

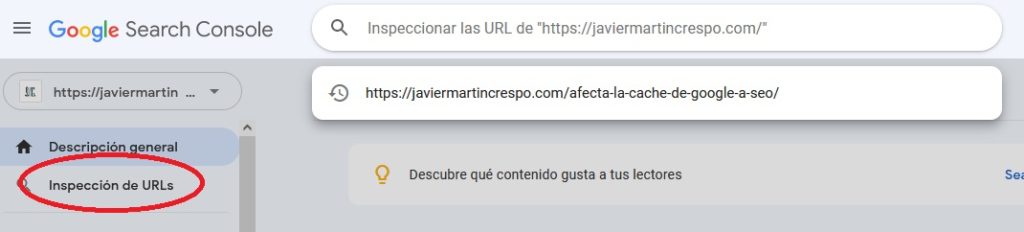

Dentro del menú izquierdo selecciona la opción “Inspección de URLs” y escribe la dirección de la página en la barra de espacio.

Al momento un mensaje te informará de la correcta indexación o no de la URL.

Si, por el contrario, quieres avisar a Google para agilizar el trámite de indexación de una nueva página existe un método manual para indexar la URL. Una opción muy útil frente a cambios o mejoras en la página posibles errores de indexación anteriores.

Dentro de la barra del menú izquierdo haz clic en “Inspección de URLs” y sitúa la URL a indexar. No olvides de poner la barra / al final de la URL o Google no localizará tu página.

Si la misma no está indexada, en la zona inferior derecha la herramienta te dará opción a hacerlo. Deberás hacerlo tanto para ordenadores como para móvil, ya que son robots diferentes los que rastrean. De igual forma, puedes dejar el campo en blanco si quieres que se rastree la home.

Normalmente el proceso de indexado queda solventado en cuestión de horas, dependiendo de la correcta trayectoria de la web incluso en minutos. No obstante, pueden producirse errores de indexado en cuyo caso sería recomendable revisar el archivo “robots.txt” entre otras causas.

Sitemap dinámico para actualizar tu contenido:

Como ya hemos comentado, tener actualizado el Sitemap de tu web ofrecerá al bot del buscador una guía directa y más rápida para saber qué páginas indexar. Gestores de uso habitual como WordPress ofrecen plugins realmente eficaces para diseñar automáticamente un Sitemap al detalle, por ejemplo el plugin Yoast SEO.

Un sitemap es un documento que lista todas nuestras páginas internas de forma jerárquica. Se trata de un documento que puede ser estático o dinámico, la diferencia reside en la capacidad de automatización para actualizar el nuevo contenido.

Un sitemap dinámico se actualiza automáticamente a medida que integramos nuevas páginas o contenidos. Disponer de un sitemap dinámico nos permite servir a los motores de búsqueda un índice actualizado garantizando un mayor control de contenidos cuya indexación puedan ser prioritarios.

Si queremos que Google rastree nuevas Urls y las indexe, la mejor manera es tener saneado y actualizado el sitemap con urls añadidas automáticamente al momento de crearlas.

Potencia tus enlaces entrantes:

Una de las acciones más útiles y olvidadas es potenciar el proceso de indexación a través de sitios externos. Es muy probable que los robots de los motores de búsqueda encuentren e indexen tu sitio cuando los sitios web que a menudo se rastrean e indexan enlazan a él.

La clave está en enlazar las nuevas páginas desde páginas externas de autoridad y relevancia. Páginas que mantengan una continua publicación de contenidos y una regular indexación de los mismos cuyo link hacia nuestra web genere confianza y facilite salto del bot de rastreo.

Optimiza los enlaces internos:

Los enlaces internos (Interlinking) son los enlaces que redireccionan de una página a otra dentro del mismo dominio. Asegurar que todas las páginas de un sitio están relacionadas entre sí ayudará a indexar una web, no obstante, siempre y cuando tengan relación y afinidad por temática o categoría.

Dentro del interlinking es siempre recomendable seguir una estrategia de enlaces jerarquizada, es decir; contar con una home indexada y a partir de ahí enlazarla correctamente con sus subpáginas. Éstas a su vez deberán enlazarse con sus páginas inferiores correspondientes de acuerdo a su categoría y así sucesivamente siempre y cuando no superes los 200 enlaces por página… De ésta forma, facilitarás enormemente el paso de los bots para su indexado.

Siempre tendrá una mayor eficacia potenciar enlaces desde tu página de más autoridad ya que ayuda a que Google agilice la indexación.

En éste punto se hace aconsejable revisar los enlaces nofollow, es decir, aquéllos que le ordenan a los bots no acceder con su rastreo. En ocasiones, ya sea por distracción o por error mantenemos éste tipo de enlaces que resultan totalmente accesibles para usuarios pero perjudican nuestros objetivos de rastreo. Para corregirlo con agilidad existen muchas herramientas que ofrecen un listado total de enlaces nofollow (Sixtrix, Ahrefs…), una vez obtenido tan sólo deberás eliminar la etiqueta nofollow o añadir un “no index” si tienes claro que la página no debe ser indexada.

En conclusión...

Indexar una página web supone una importante tasa de visitas fomentadas por el posicionamiento que te otorga el SEO. Saber qué mecanismo siguen los bots y que acciones priorizan en su proceso de rastreo será una hábil opción para optimizar las visitas y objetivos de tráfico a la web.

Si bien es cierto que acciones como la definición del Sitemap, la optimización de enlaces internos o la calidad de enlaces entrantes no son decisorios para la indexación de una página si otorga seguridad y facilita el proceso de rastreo. El SEO y la indexación están íntimamente ligados y supone un proceso global que abarca la optimización de muchos elementos tanto on como offpage para potenciarlo.

¿La clave…? Cuidar todos y cada uno de los aspectos on-offpage como si tuviesen igual relevancia. A veces, y sobre todo ante tanta competencia, un pequeño detalle puede suponer un incremento en posiciones.