El análisis SEO de logs supone uno de los factores clave frecuentemente ignorados a la hora de potenciar la estrategia SEO. Su optimización permite conocer como los motores de búsqueda rastrean nuestra web a la vez que permiten detectar importantes errores SEO.

Los logs o registros son archivos generados por un servidor web y que muestra las solicitudes recibidas. Con el análisis de registros vamos a evaluar la fiabilidad del rastreo de los bots de los diferentes motores de búsqueda en nuestra plataforma.

El Registro de toda ésa actividad en nuestra web permitirá interpretar conclusiones de mejora en posicionamiento en relación al estado del rastreo y indexación.

Temas del artículo

¿Qué es un log?

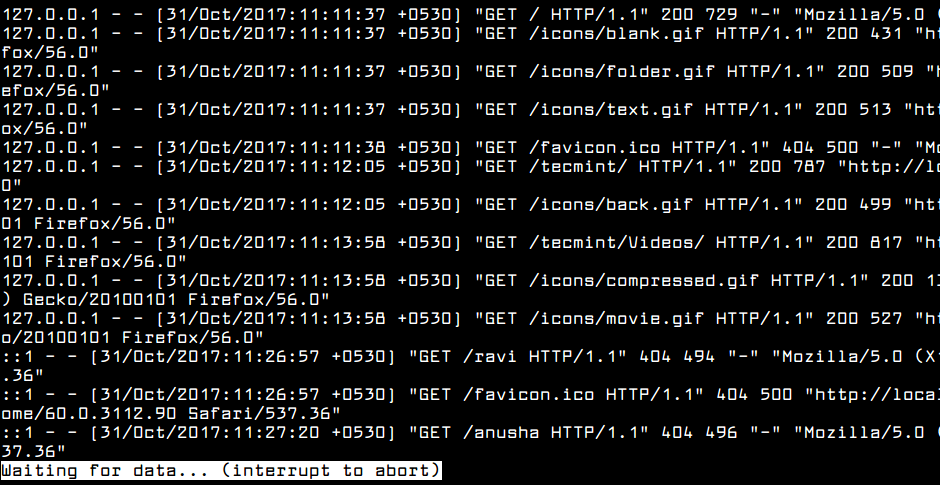

Para definirlo de forma breve; un log es un fichero que guarda todas las peticiones (“Request”) realizadas al servidor que aloja nuestra web. Cada petición generada ofrece una entrada que incluye la fecha y hora de la solicitud, dirección IP, contenido que se ha solicitado y user-agent del navegador.

Al acceder a una página web requerimos información al servidor (Hosting) donde se encuentran los datos alojados. Una vez solicitados los datos al servidor éste los dirige y el propio navegador los interpreta componiendo la parte visual de la página web (Archivos HTML, CSS, JS, imágenes …)

¿Cómo se estructura un log?

Estructuralmente, su contenido suele englobar:

- IP del cliente desde donde se hace la petición

- Fecha y hora: Fecha y hora a la que se realizó la petición al servidor

- Tipo de petición: método utilizado para requerir la información al servidor

- URL rastreada: URL a la que se ha realizado la petición y el formato del propio archivo requerido

- Protocolo seguido: Protocolo con el que se ha realizado la petición

- Código de respuesta http: Código de respuesta del servidor

- User-agent: User Agent que ha realizado la consulta

Toda ésta información es almacenada en el fichero log para cada una de las solicitudes realizadas al sitio web y supone una cantidad enorme de información útil para analizar cómo se comportan los bots en nuestra web.

Generalmente, el análisis de ficheros log se asocia a proyectos con un gran número de URLs pero siempre será útil una interpretación de los mismos para tener una perspectiva del comportamiento de los bots con datos obtenidos directamente del servidor.

¿Por qué es importante el análisis SEO de logs?

Analizando los logs podremos saber exactamente qué es lo que están haciendo los buscadores en nuestra web y entender mejor cómo sus robots llevan a cabo el rastreo. Un indicador importante para conocer la frecuencia de rastreo, paginas indexadas, afinidad del presupuesto de rastreo o posibles errores a corregir (404, redirecciones…)

El análisis SEO de logs también puede aportar información muy útil relacionada no sólo con la frecuencia de rastro por parte de los buscadores, sino también, qué buscadores rastrean más frecuentemente la web y con qué navegador lo hacen para optimizar el proceso de renderización.

El análisis de logs resulta especialmente útil frente a webs grandes. Estructuras de muchas URLs en las que los buscadores no llegan de similar manera a la información ya sea por los límites en el crawl budget, por niveles defectuosos de profundidad o por la calidad del contenido.

En ocasiones, dentro de las peticiones que se hacen al servidor se encuentran las realizadas por herramientas externas de análisis digital como Screaming Frog que pueden perjudicar la objetividad de nuestros análisis. La información de los logs ofrecen una mayor objetividad en la procedencia de los registros.

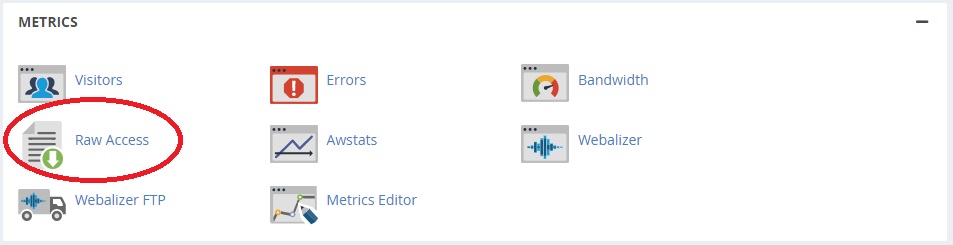

¿Cómo acceder a los ficheros log en Cpanel?

El acceso a los ficheros log es una tarea sencilla aunque dependerá del servidor en el que esté alojada cada web. Aplicaciones FTP como Filezilla ofrecen una opción directa y sencilla para localizarlos situándolos en una carpeta directa. No obstante, en la mayoría de los casos tendrás que acceder al panel del hosting donde está alojada la web y descargar los archivos.

Accediendo a CPanel, dentro del módulo de métricas podrás visualizar una carpeta llamada “Acceso sin procesar”. Haciendo clic en la misma podrás localizar la serie de archivos para descargar.

En éste punto es importante recalcar que los archivos de logs no se guardan por tiempo indefinido y su publicación dependerá de cada compañía de hosting. Los archivos de logs pueden llegar a ser enormes debido a la gran cantidad de información en líneas de código que agrupan. Por ello, los logs se guardan en archivos comprimidos (.tar.gz) que suelen eliminarse pasado un periodo para no saturar el servidor.

De ésta forma, guarda control regular de la disponibilidad para tener seguro el acceso, gestión y análisis de tus logs.

¿Qué ventajas podemos sacar del análisis SEO de logs?

Analizar el crawl budget

El crawl budget (Presupuesto de rastreo )se refiere al número de páginas que un bot es capaz de rastrear en un periodo de tiempo concreto. Cada proceso de rastreo variará en función del tamaño de la web, la facilidad de rastreo y la frecuencia con la que se actualiza nuevo contenido en el site.

Los bots que dirigen los buscadores no rastrean totalmente la web cada vez que la visitan, sino que acceden al contenido prioritario y destinando un tiempo limitado para llevar a cabo el rastreo. Por ello, es fundamental dirigir el presupuesto de rastreo hacia las páginas que más nos interesan. El objetivo prioritario es que el crawl budget se centre en el análisis de aquellas páginas que son clave para el proyecto y no se pierda en otras que no nos interesan.

En contextos de páginas con muchas URLs, puede suponer un riesgo llevar al bot a zonas de la web que no nos interesan y desperdiciar ése tiempo limitado de rastreo.

Mediante el análisis SEO de logs podemos controlar el paso de los bots por la web y tener supervisadas todas las posibilidades de rastreo. El análisis de los ficheros de logs nos asegurará si nuestro archivo robots.txt o etiquetas meta-robots están optimizadas cumpliendo nuestros objetivos de acceso o si, por el contrario, los bots acceden a partes de la web que no son de interés.

Crawleo de URLs duplicadas

De igual manera, el análisis SEO de logs ofrece información muy útil sobre el rastreo de URLs de similar contenido. Sobre todo aquellas en las que la diferenciación viene definida por categorizaciones o parámetros internos que genera la web.

Sobre todo en contextos de ecommerce los filtros pueden definir una misma URL:

ejemplo.com/producto/bolso

ejemplo.com/producto/bolso?color=rojo&talla=grande&botones=amarillos&cuero=blanco

En caso de que no queramos que el bot pierda tiempo de rastreo en este tipo de URLs parametrizadas la mejor opción será siempre usar el robots.txt para bloquearlas.

Una vez analizados los logs podremos definir la prioridad sobre las mismas y fundamentalmente el acceso de rastreo sobre las que consideremos prioritarias.

URLs más rastreadas

Analizando los movimientos de rastro del bot sobre nuestras URLs obtendremos información clave para detectar si sus visitas se producen sobre el nicho duro de nuestro negocio, es decir, sobre las páginas más importantes para conseguir nuestros objetivos de venta.

A través del análisis SEO de logs podemos detectar si el bot está perdiendo el tiempo en rastrear páginas secundarias que no alineadas con los objetivos del negocio.

Un análisis con el que podremos estudiar la prioridad de rastreo del buscador y compararla con nuestras prioridades para modificar su acceso mediante robots.txt, enlazado o contenido.

URLs sin rastrear

Completando la información anterior, el análisis de logs sobre nuestras URLs nos aportará información relevante sobre las URLs clave de negocio que no se muestran en sus reportes.

Páginas de nuestro site que no han sido rastreadas por los bots y conforman un claro objetivo de negocio por lo que recuperarlas potenciando en linkbuilding o enlazado interno deberá suponer un objetivo prioritario.

Resolver errores de código de estado

El análisis SEO de logs permite analizar los errores encontrados por los bots al intentar acceder a los diferentes contenidos del site.

Si bien es cierto que muchas herramientas de análisis (Screaming Frog, AHrefs…) ofrecen listados importantes de errores de código incluyendo una localización precisa, nada como contar con la fuente directa del proceso de rastreo, es decir, los movimientos que ha ido llevando el log en su proceso de rastreo.

Si en su proceso de rastro el bot encuentra numerosos errores 404 provocados por páginas ya no disponibles deberemos activar las correspondientes redirecciones 301 para mantener óptimo el proceso de rastreo.

Un perfil adecuado podrá definir la solución para los errores de código de estado HTTP localizados y la solución para potenciar nuestro posicionamiento orgánico.

Frecuencia de visitas del bot

El proceso de rastreo es parte indispensable de toda estrategia SEO. Si nuestro contenido no llega al buscador, tanto si no lo rastrea en profundidad como si prioriza lo no relevante, será inviable cualquier objetivo de indexación y posibles visitas.

El análisis SEO de logs nos permite saber que páginas y secciones de la web no están siendo recorridas por los bots.

Una vez encontrados, será necesario implementar una nueva estrategia en el sitio para que esas zonas sean rastreadas pudiendo definir acciones de respuesta potenciando el enlazado interno o la arquitectura del site. De igual forma, una optimización del sitemap nos permitirá facilitar la llegada de los bots fomentando con mayor agilidad la indexación.

Además, conociendo el número de peticiones diarias realizadas por un bot al servidor nos permitirá saber cuales son las URLs más visitadas ofreciendo conclusiones muy objetivas sobre la frecuencia de rastreo, las páginas que prioriza y la efectividad del presupuesto de rastreo en nuestra estrategia.

Códigos de errores 404, 301 o 500

Cada proceso de indexado requiere una supervisión continua. En el contexto de las redirecciones, por ejemplo, es frecuente que los bots sigan insistiendo en indexar la URL inicial. Analizando los logs puedes ver el seguimiento real de códigos de respuesta que se encuentran los buscadores, una alternativa muy útil para plantearte borrados, correcciones o aparición de cadenas de redirección.

Si tienes un poco olvidado el contexto de las redirecciones y su importancia en la estrategia SEO te dejo un link sobre el riesgo en las cadenas de redirección 301 y cómo perjudican el paso de los bots en su proceso de indexación.

Un análisis detallado brindará una optimización en códigos de respuesta muy útil; localizando URLs con errores 404 en páginas que ya no están disponibles o identificando errores 505 de acceso al servidor (Con el correspondiente riesgo para el rastreo e indexación)

Una vez localizado el código de error tan sólo quedaría plantear la solución más viable; ya sea mediante la corrección del enlace con error, limpieza de enlaces que apuntan a URLs antiguas, comprobación de links o revisión de URLs definitivas.

Protocolos HTTP y HTTPS

El protocolo HTTPS hace que cualquier tipo de información que se transmita en la red sea cifrada y nadie pueda acceder a ella salvo el navegador y el servidor. La principal diferencia entre HTTP y HTTPS es la seguridad.

El protocolo HTTPS evita que otros usuarios puedan acceder a información confidencial transferida entre el cliente y servidor dentro de la web.

El análisis SEO de logs facilitará el poder observar si URLs con protocolo HTTP siguen teniendo clics situando, si fuese necesario, una posible redirección

Exceso de carga en la web

Finalmente, y no menos importante, el análisis de logs puede darnos ciertas perspectivas muy útiles sobre la velocidad de carga de la página.Una web ágil de respuesta rápida no sólo potenciará la usabilidad y permanencia del usuario, sino que también incrementará la capacidad del bot para rastrear más páginas.

En este sentido, revisar los logs nos permitirá detectar elementos internos que incrementan el peso de las páginas como el exceso de archivos PDF o la falta de compresión.

En conclusión…

El análisis SEO de logs puede ayudarte a detectar muchos errores técnicos en la web. En casos de webs con muchas URLs resulta clave su uso ante acciones de monitorización, migraciones o corrección de URLs

Los análisis de logs aportarán un reporte adicional para impulsar acciones de crecimiento en la web, toda una oportunidad para mejorar la visibilidad orgánica.Una opción obligatoria para poder optimizar el crawl budget y obtener una mejora en el posicionamiento orgánico.