A la hora de plantear un post sobre acciones de SEO avanzado hago indispensable partir de un contexto donde mantengamos una estrategia SEO vigente cuidada y supervisada de forma regular, es decir, optimizada en sus elementos on-off page de forma contínua con testeos que permitan una evolución a mejores resultados.

Éste post va más allá de otros dedicados a posicionamiento, muy enfocados al SEO de contenidos y onpage como optimizar un research de keywords, redactar metas y descriptions… sobre como potenciar el mejor Alt para las imágenes o la importancia de un enlazado interno…

La idea es avanzar más a fondo… potenciando acciones directamente asociadas a la indexación, el crawleo o la optimización del código. Áreas donde apenas se suele hacer hincapié pero que son clave en un contexto donde pueden suponer el elemento diferenciador en tu estrategia SEO para generar mayores resultados de posicionamiento .

Os muestro mis 5 acciones clave para una estrategia de SEO avanzada…

Temas del artículo

Planifica y adapta tu arquitectura web

Una de las primeras, primerísimas, acciones a tener en cuenta en toda estrategia de posicionamiento SEO es, precisamente, la organización de la misma página web, en concreto su estructura y menú de navegación.

Con el paso de los años ya se ha establecido un diseño de menú estándar (Menú horizontal en la parte superior de la página con orden de prioridad de izquierda a derecha) que optimiza tanto la publicación del contenido como la forma usable para llegar a él con el menor número de clics posibles. Tratar de modificarlo y buscar la originalidad y diferenciación puede resultar un riesgo importante si tu usuario no consigue cumplir con su objetivo.

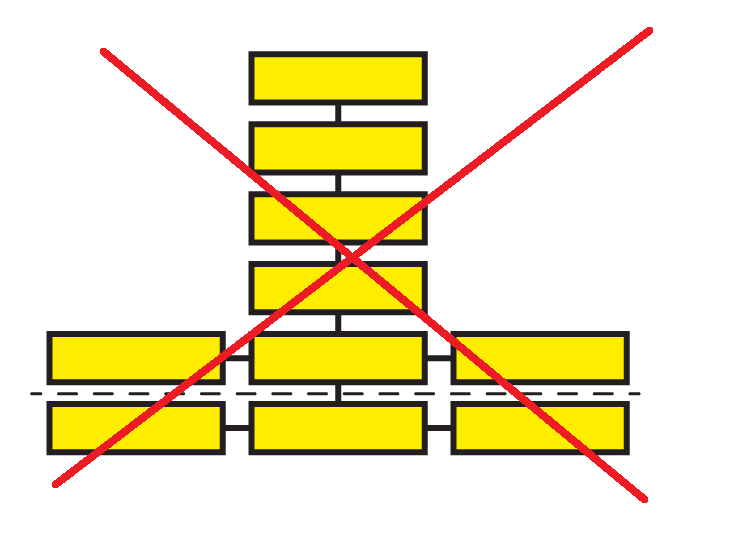

Apuesta por un sistema de estructura horizontal. Los robots de los buscadores tienen un tiempo limitado en su proceso de rastreo por lo que debemos ponérselo lo más sencillo posible y esto pasa por establecer una estructura que no supere los 3 niveles de profundidad sin tener en cuenta la home principal. Cuantos más niveles tenga que atravesar el bot menos tiempo le quedará para acceder a las páginas más importantes.

Recuerda que el objetivo de toda web es comunicar un contenido y dentro del mismo hay prioridades de acuerdo a su valor. No olvides situar el contenido más relevante en las áreas de profundidad superiores próximas a la home, donde el usuario pueda llegar con apenas 3 o 4 clics.

De igual forma y más allá de la pura usabilidad en la web debemos entender que una arquitectura bien planificada apoyará enormemente la interpretación de la temática por parte de los buscadores en relación a su proceso de indexación. Es la forma más eficaz de hacer entender la estructura de la web y priorizar en los buscadores las páginas con mayor relevancia.

Y si hablamos de indexación lo hacemos, también, de crawleo y rastreo porque la optimización en la estructura web también afectará a las “arañas”de los buscadores. Una estructura lineal y sencilla ofrecerá un camino más directo a los bots en su proceso de rastreo y ampliarán sus opciones de descubrir más contenido en relación a sus límites de tiempo para hacerlo.

Finalmente, no olvides la importancia de las keywords; organizando el contenido y sus palabras clave por afinidad dentro de la estructura global, es decir, una estructura semántica que aproxime páginas por similitud de términos .

Crawl Budget: Optimiza el bot de rastreo

Como ya sabéis, Google, para situar y ceder prioridades de posicionamiento a cada una de las páginas dirige un pequeño bot de rastreo a la web. Se trata de una aplicación que recorre e investiga la página web para dotarla de significado e interpretarla cara a su futuro posicionamiento.

Pero éste proceso de rastreo tiene un límite de tiempo por visita por lo que a la hora de enfocarlo es necesario seleccionar qué páginas queremos que visite, es decir, priorizar aquéllas de mayor relevancia y más descriptivas para el usuario que fomenten con su indexación las visitas del mismo.

- Optimiza tus enlaces:Ten claro que debemos facilitar el camino y ayudar a llevarlo a cabo al bot. Por ello, una de las primeras medidas que siempre se recomiendan tiene que ver con los enlaces; optimizando los enlaces internos y redirigiendo a resultados directos de código 200. De igual forma, evita enlaces a páginas poco relevantes que “despisten” la trayectoria y enfoque del rastreo en marcando como No-index su contenido.

- Control de Ajax/JavaScript: Abusar de la activación de elementos como JavaScript, frames, Flash o Ajax puede resultar perjudicial ya que al bot de google le cuesta identificarlos e indexarlos. Evita su uso en las páginas más relevantes.

- Optimiza tu archivo Robots.txt: Éste archivo es realmente útil para controlar el proceso de rastreo del bot y darle instrucciones de donde enfocar su tiempo de rastreo. Limita las páginas menos relevantes para tu usuario.

- Potencia tu contenido: Supone una de los puntos clave de toda estrategia SEO y en éste punto no sólo basta con diseñar un contenido atractivo y que genere interés… de igual forma deberás preocuparte por hacer que el bot lo indexe. Los contenidos que se rastrean con mayor frecuencia potencian su visibilidad y exposición, es decir, generan mayor audiencia.

- Cuida tu Page Rank: El nivel de calidad de una web viene definido por la infinidad de medidas SEO que sobre la misma hay que potenciar. En una estrategia de posicionamiento existen factores SEO de mayor y menor valor pero para conseguir optimizar tu autoridad de página deberás potenciarlos todos al máximo. En éste punto es necesario comprender que dependiendo del page Rank de cada página Google asigna un determinado crawl budget o proceso de rastreo.

Configura Sitemap y Robots en tu web

Mediante un correcto diseño del Sitemap informaremos a los buscadores de la organización de nuestro site incluyendo páginas y secciones, relevancia de las mismas y frecuencia de actualización de contenidos para que los bots de rastreo recopilen la información, la almacenen en su base de datos y, finalmente, nos clasifiquen cara al proceso de búsqueda del usuario.

Será indispensable mostrar un Sitemap claro y concreto; que incluya las etiquetas obligatorias de comienzo y cierre (<urlset> / </urlset> ), definiendo cada URL con su etiqueta <url> y su etiqueta <loc>.

Existen herramientas de enorme calidad para diseñar tu propio archivo de forma manual o automática mediante plugin especializados (Google XML Sitemap, Sitemaps Generator Tool…) con opciones muy básicas y descriptivas para detallar la estructura de tu web. Posteriormente, tan sólo quedará subir el archivo al directorio raíz del sitio web y, mediante, Search Console, notificarlo a Google.

De igual forma, mediante el archivo Robots.txt informaremos a los bots de rastreo de lo que queremos indexar o no. Pero su verdadera utilidad no se reduce a informar de las páginas que no queremos indexar, tiene un uso clave para potenciar aquéllas que queremos priorizar.

Para diseñarlo tan sólo deberás diseñar las condiciones en una hoja de bloc de notas y subirlo al directorio raíz de la web donde será públicamente accesible bajo la forma https://www.tu-web.com/robots.txt.

Y éstas serán las configuraciones vigentes para definirlo:

User-agent: – Define si el valor va dirigido a un robot en particular o a todos.

Disallow: – URL o archivo que necesitamos bloquear.

Allow: – URL o archivo que permitimos su rastreo

Por ejemplo, si quisiésemos bloquear el rastreo del robot de Google hacia la categoría o carpeta llamada “ventas” de nuestra web ni una página con la terminación “productos.html” deberíamos mostrarlo así:

User-agent: Googlebot

Disallow: /ventas/

Disallow: productos.html

Ojo!! Tal y como ya hemos comentado, deberás situar el archivo robots.txt en la raíz del servidor web, es únicamente donde los bots lo buscarán. La carpeta raíz vendrá nombrada como htdocs o public_html según el tipo de sistema operativo del servidor.

Aumenta la velocidad de carga de tu sitio web

Controlar la velocidad de carga en la página web supone uno de los factores SEO más importantes y menos valorados por la mayoría de las marcas y una acción cada vez más solicitada en los últimos algoritmos de Google.

No sólo supone un elemento clave en la estrategia de posicionamiento, sino también, en la optimización de la usabilidad y en la consecución posterior de los objetivos de generación de leads y conversión potenciando la permanencia del usuario.

En primer lugar, elige un paquete de hosting adecuado para el tamaño de tu sitio web porque afectará de forma directa a la velocidad de carga en la página. Si se producen caídas y errores de conexión frecuentes será necesario obtener un proveedor de hosting diferente. De igual forma, la seguridad puede provocar muchas consecuencias negativas para tu estrategia SEO en relación con ataques de hackeo.

Otro punto clave es tratar de comprimir las imágenes al máximo manteniendo siempre las dimensiones de la misma conjugando el peso adecuado pero sin mermar por limitaciones la calidad de imagen y su pixelado.

Y una sugerencia más… crea un único archivo con todos los CSS y unifica, también, la funcionalidad de los javascripts que se activen con la carga.

Si cuentas con una página en WordPress el uso de plugins enfocados a mejorar la velocidad de carga pueden ser una gran alternativa ya que automáticamente redimensionan y optimizan los tamaños excesivos, os dejo tres buenas opciones:

–WP Rocket: Un plugin más que efectivo con opciones de almacenamiento en caché de las páginas, precarga de la caché y reducción del peso en archivos HTML, JavaScript y CSS

–WP-Optimize: Una opción para espaciar y filtrar la base de datos para que vaya más rápida.

–WP Smush: Una gran utilidad para optimizar el tamaño de las imágenes y mejorar su rendimiento cara a la carga general.

Y como complemento a todo ello es indispensable medir, medir y medir… analizar si los cambios de formato y tamaño han tenido resultado y en qué cantidad de acuerdo al proceso de carga, aquí os dejo dos herramientas que por simplicidad y concreción me parecen las mejores opciones para medir tu carga:

– PageSpeed Insights: la propia herramienta de Google, una opción efectiva y fiable no sólo para analizar el contenido de tu web sino también para obtener sugerencias para mejorar la velocidad de carga.

–GTMetrix: Una opción con la que obtener un análisis rápido, con tablas en detalle de tiempo, tamaño, solicitudes por visita… sugerencias de mejora y opciones de creación de alertas personalizadas.

–Pingdom: Un test sencillo y rápido de carga con opciones de tiempo de actividad, rendimiento e interacciones.

Código sencillo, estructurado y sin errores

Es uno de los factores que siempre olvidamos y apenas damos relevancia; el código donde optimizamos muchos elementos onpage. Debemos entender que en el proceso de rastreo que hacen los bots debemos ponérselo lo más fácil posible. En su recorrido por nuestro contenido recorrerán todo nuestro código y si éste está mal definido, engordado y con elementos poco relevantes le harán perder si tiempo de rastreo.

Sitúa una estructura y código ordenado; con una estructura de directorios y archivos bien definida. Con carpetas o subdominios para cada sección en tu web, con usos de tags <h1> y <b> , con definición de títulos, uso de las negritas, metas únicos para cada página…

Como siempre comento; el SEO es una estrategia global, llena de factores a tener en cuenta, grandes y pequeños, de mayor o menor relevancia… dominar ése primer SEO básico de los contenidos, imágenes y elementos onpage es una garantía para avanzar ysentar las bases hacia éstas nuevas medidas que se hacen cada vez más relevantes a la hora de potenciar posiciones….

¿Me cuentas las tuyas…? 😉